继B轮融资5000万美元后,Hume AI 推出有情感感知能力的对话AI EVI

多知4月1日消息,近日,Hume AI 近日发布了具有情感感知能力的对话 AI EVI。EVI 采用了情感大语言模型(eLLM)技术,这是一种结合了大型语言模型的语言理解和表情测量技术的情感感知能力。

使用 EVI 的主要方式是通过 WebSocket 连接实时发送音频并接收响应。这可以实现流畅的双向对话,用户可以说话,EVI 可以倾听并分析他们的表情,EVI 可以生成情感智能的响应。

用户可以通过连接到 WebSocket 并将用户的语音输入流式传输到 EVI 来开始对话。您还可以发送 EVI 文本,它会大声朗读该文本。

“想象一下,一个能够理解你的沮丧或喜悦的人工智能助理,一个能够理解你抱怨的客户支持代理,甚至是一个能够提供真正情感支持的虚拟治疗师。”这些就是Hume AI可以提供的,可以说,Hume AI满足了人类的情绪价值。

Hume.ai首席执行官兼首席科学家Alan Cowen表示,将共情AI应用于人类生活当中,这对于日常交流、医疗非常重要。通过构建直接从人类幸福感代用指标中学习的AI,我们正在有效地教会EVI从第一原理出发重建人类的心理、兴趣偏好,然后根据它与每个新的人交谈和嵌入的每个新的应用程序完成自我迭代和升级。

一周之前,Hume AI刚刚获得了 5000 万美元的 B 轮融资,本轮融资由 EQT Ventures 领投,Union Square Ventures、Nat Friedman & Daniel Gross、Metaplanet、Northwell Holdings、Comcast Ventures 和 LG Technology Ventures 跟投。

Hume AI 可以在机器人、医疗保健、健康等领域得到应用。

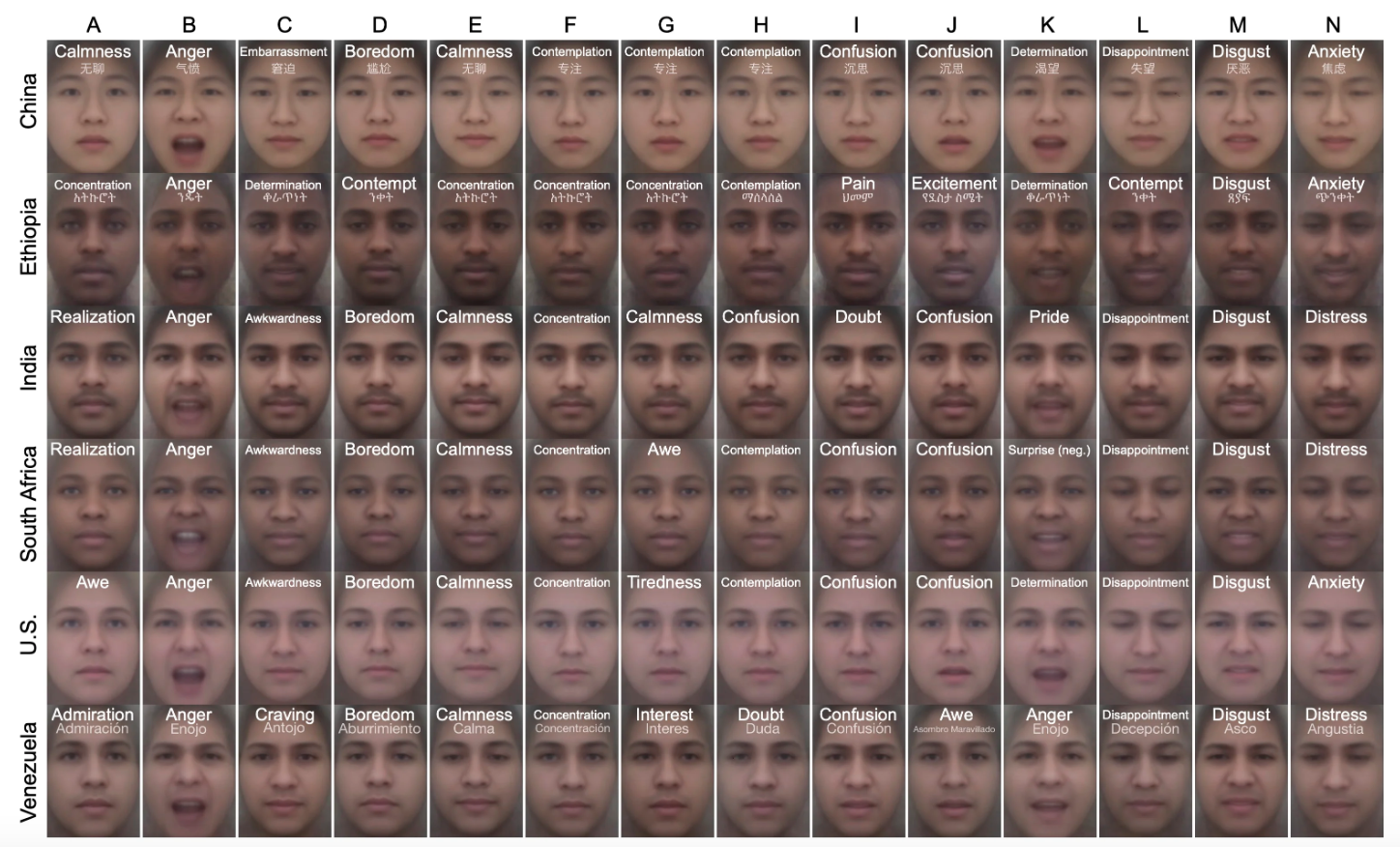

(Hume AI 模型可以区分跨文化共有的 28 种不同的面部表情示例)

Hume AI 提供了表情测量API和自定义模型API,适用于需要理解和预测人类情感、行为的研究人员、开发者和企业。

而EVI 这些功能使人类与人工智能之间的语音交互更加顺畅,为个人人工智能、客户服务、可访问性、机器人、沉浸式游戏、VR 体验等开辟了新的可能性。(多知 Penny)